원본이미지에 1개의 object가 있는 경우

image classification과 똑같은 순서이고

예를 들어 (224, 224) 라고 하고

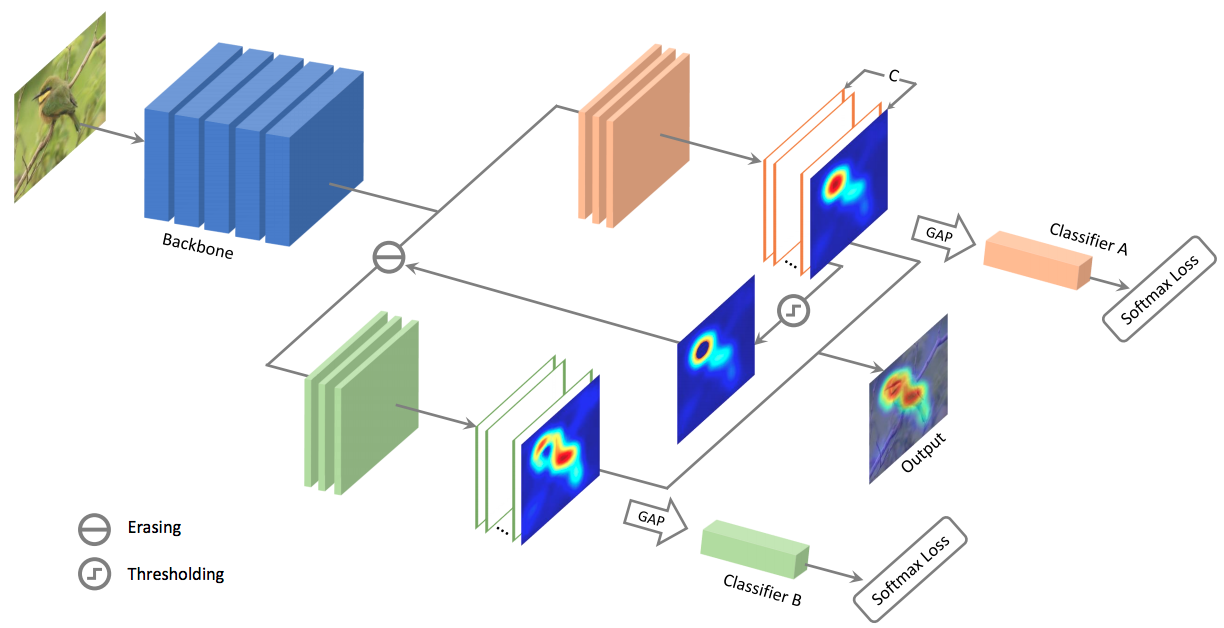

VGG16과 같은 back bone 즉, Feature Extrator에 이미지를 입력하게 된다.

backbone의 역할은 이미지 내에서 중요한 피처를 추출하는 것이다.

그것을 통해서 최종적으로 feature map이 만들어짐

가령 feature map은 (7, 7)이 되어 size는 작아지는데, 대신 채널 수는 늘어나게 됨 (7, 7, 512)

원본이미지 대비 축약된, 추상화된 이미지가 생성된다.

그리고 보통 img와 label을 maping시키고, 학습을 해놓음

그리고 softmax 함수로 class score를 매겼을 때 {car : 0.8, cat : 0.1, dog : 0.1 } 이러면 car이 된다.

3000개 img들로 각각 1000장씩 학습을 시키고

layer [ Dense layer, softmax 함수, fully connected ]로 학습시킴

=> img classification 원리

annotation 파일에 object, bounding box 좌표(xmin, ymin), (xmin, ymin)가 입력이 되어있다.

혹은 yolo는 center 좌표로 지정하기도 함.

object localization 은 여기서 bounding box regression이 또 있음.

각각 label을 각각 좌표에 예측을 해봄

feature map은 map당 object가 딱 하나니깐 map에 이런 특성이 나오면 해당 bounding box regression을 적용한다.

그러면 잘나옴

그리고 object를 학습시키고, 가중치를 부여하면서, 여러 각도, 여러 이미지를 통해서 학습시킨다.

이 feature가 있으면 maping을 한다가 됨.

yolo의 경우 예측결과가 class confidence score이 있음

object detection으로 2개 이상의 object를 검출하면 거기에 문제가 생김

문제가 유사하게 적용했는데 각각 좌표가 이상한 곳에 찍힘

inference가 이상한 곳에 찍힘.

1000장의 이미지가 있으면 각각 학습시키면서 feature 특징은 학습했는데 feature 좌표를 획득하는데 문제가 생긴다.

예를 들어 중간값으로 좌표를 찍는 식으로

object가 있을 만한 위치를 먼저 찾아주고, 그 위치의 object를 탐색하는 방식이 보통 방식임

=> Region proposal

대충 가이드라인은 나눠줘야 번잡하지 않다.

'Computer_Science > Computer Vision Guide' 카테고리의 다른 글

| 1-7. IoU 성능평가 [colab] (0) | 2021.09.11 |

|---|---|

| 1-6. selective search 시각화 [colab] (0) | 2021.09.11 |

| 1-4~5. Region Proposal(영역추정) (0) | 2021.09.11 |

| 1-2. Object Detection 주요 구성 요소 (0) | 2021.09.10 |

| 1-1. object detection 개요 [딥러닝 컴퓨터 비전 완벽가이드 필기] (0) | 2021.09.09 |